Java埋點數據庫架構 千萬級調用量微服務架構下的數據處理實踐

在當今大數據和實時分析驅動的業務環境中,Java埋點數據的處理成為了業務決策和用戶體驗優化的核心。尤其是在千萬級調用量的微服務架構下,如何設計高效、穩定的數據處理服務,是每一位架構師和技術大牛必須面對的挑戰。本文將從數據庫架構設計、微服務架構實踐以及數據處理服務優化三個方面,深入探討千萬級調用量場景下的Java埋點數據處理方案。

一、Java埋點數據庫架構設計

- 數據采集與存儲分層

- 在千萬級調用量下,數據采集需采用異步和非阻塞的方式,避免對業務服務造成性能影響。常見的做法是使用消息隊列(如Kafka)作為數據緩沖層,將埋點數據先寫入隊列,再由數據處理服務消費。

- 數據庫存儲方面,采用分層存儲策略:原始數據存儲在分布式文件系統(如HDFS)或NoSQL數據庫(如HBase)中,聚合后的結果數據則存入關系型數據庫(如MySQL)或時序數據庫(如InfluxDB),以支持快速查詢和分析。

- 數據庫選型與優化

- 對于高吞吐量的埋點數據,推薦使用列式存儲數據庫(如ClickHouse)或時序數據庫,它們在大規模數據寫入和聚合查詢上具有顯著優勢。

- 索引設計是關鍵,需根據查詢模式創建合適的索引,避免全表掃描。同時,通過分庫分表策略(如按時間或業務維度分片)來分散讀寫壓力。

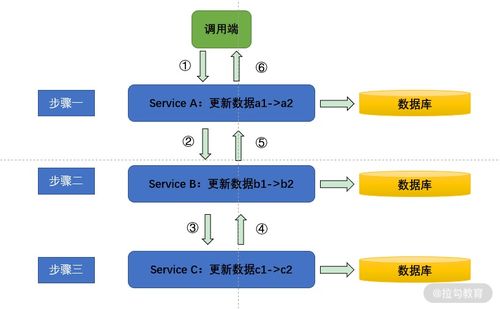

- 數據一致性與可靠性

- 采用最終一致性模型,通過消息隊列的確認機制和重試策略,確保數據不丟失。對于關鍵業務數據,可引入事務性消息或分布式事務(如Seata)來保障一致性。

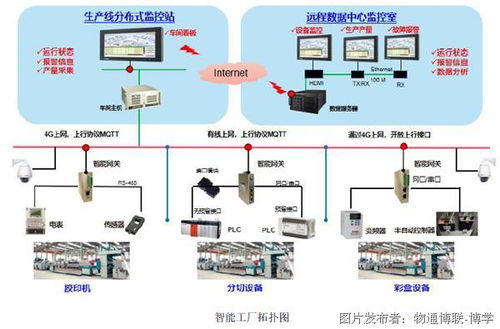

二、千萬級調用量微服務架構實踐

- 微服務拆分與治理

- 將數據處理服務拆分為獨立的微服務,如數據采集服務、數據清洗服務、數據聚合服務等,每個服務專注于單一職責,便于水平擴展和維護。

- 使用服務網格(如Istio)或API網關(如Spring Cloud Gateway)進行流量管理、負載均衡和熔斷降級,確保系統在高并發下的穩定性。

- 彈性與可擴展性

- 采用容器化部署(如Docker和Kubernetes),結合自動擴縮容策略,根據CPU、內存或自定義指標(如隊列積壓)動態調整實例數量。

- 利用緩存(如Redis)存儲熱點數據,減少數據庫訪問壓力,并通過CDN加速靜態資源的分發。

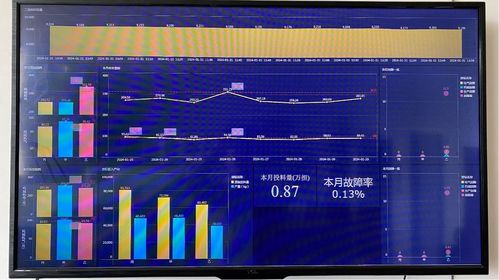

- 監控與告警

- 集成分布式追蹤系統(如SkyWalking或Zipkin)和指標監控工具(如Prometheus),實時監控服務性能和數據流狀態。設置智能告警規則,及時發現和處理異常。

三、數據處理服務的關鍵優化點

- 高性能數據處理流水線

- 使用流處理框架(如Apache Flink或Spark Streaming)構建實時數據處理流水線,支持窗口聚合、復雜事件處理和狀態管理。

- 優化數據序列化格式(如Avro或Protobuf),減少網絡傳輸和存儲開銷。

- 資源管理與調度

- 在微服務中,通過線程池、連接池和異步編程模型(如CompletableFuture或Reactor)提升資源利用率。避免阻塞操作,確保系統響應迅速。

- 對于批量處理任務,采用分布式調度框架(如Apache DolphinScheduler)協調任務執行,提高整體吞吐量。

- 數據質量與治理

- 引入數據校驗和清洗規則,在數據入口處過濾無效或重復數據。通過數據血緣工具追蹤數據流向,保障數據可信度。

- 定期進行數據歸檔和清理,防止存儲膨脹影響性能。

四、大牛的經驗分享

在實際項目中,技術大牛們強調以下幾點:

- 盡早規劃容量:根據業務增長預測,提前進行容量規劃,避免系統在流量激增時崩潰。

- 持續性能調優:通過壓測和 profiling 工具(如Arthas)識別瓶頸,不斷優化代碼和配置。

- 自動化運維:利用CI/CD流水線和基礎設施即代碼(IaC)工具,實現部署和運維的自動化,降低人為錯誤。

- 容災與備份:設計多活架構和定期備份策略,確保數據安全和服務高可用。

結語

Java埋點數據處理在千萬級調用量的微服務架構下,是一項復雜而關鍵的任務。通過合理的數據庫架構設計、彈性的微服務實踐以及高效的數據處理優化,可以構建出穩定、可擴展的數據處理服務。未來,隨著邊緣計算和AI技術的融合,埋點數據處理將更加智能和實時,為業務創造更大價值。希望本文的實踐分享能為您的項目提供參考,助力您在數據洪流中乘風破浪!

如若轉載,請注明出處:http://www.supportcoun.cn/product/6.html

更新時間:2026-01-11 16:06:43